AI發展是否停滯 The Scaling Law 20241212,探討AI發展是否停滯?,從語言模型的擴展與精簡談起,引用楊立坤博士的「世界模型」,強調AI未來不僅限於文字訓練,還需整合圖片、聲音等多模態數據。AI並未停滯,而是以文字為主的模型達到瓶頸,未來還有巨大的發展空間。

AI發展是否停滯 The Scaling Law 影片

嗨,我是亞瑟,我有三高。今天我們來談談AI的發展是否停滯了,順便聊聊副標題:The Scaling Law

The Scaling Law

- AI發展的兩大議題

- 模型越做越大能力未提升

- 模型精簡導致運作問題

- Scaling Law for Precision

- 楊立坤提出『世界模型』

https://time.com/7178328/is-ai-progress-slowing-down

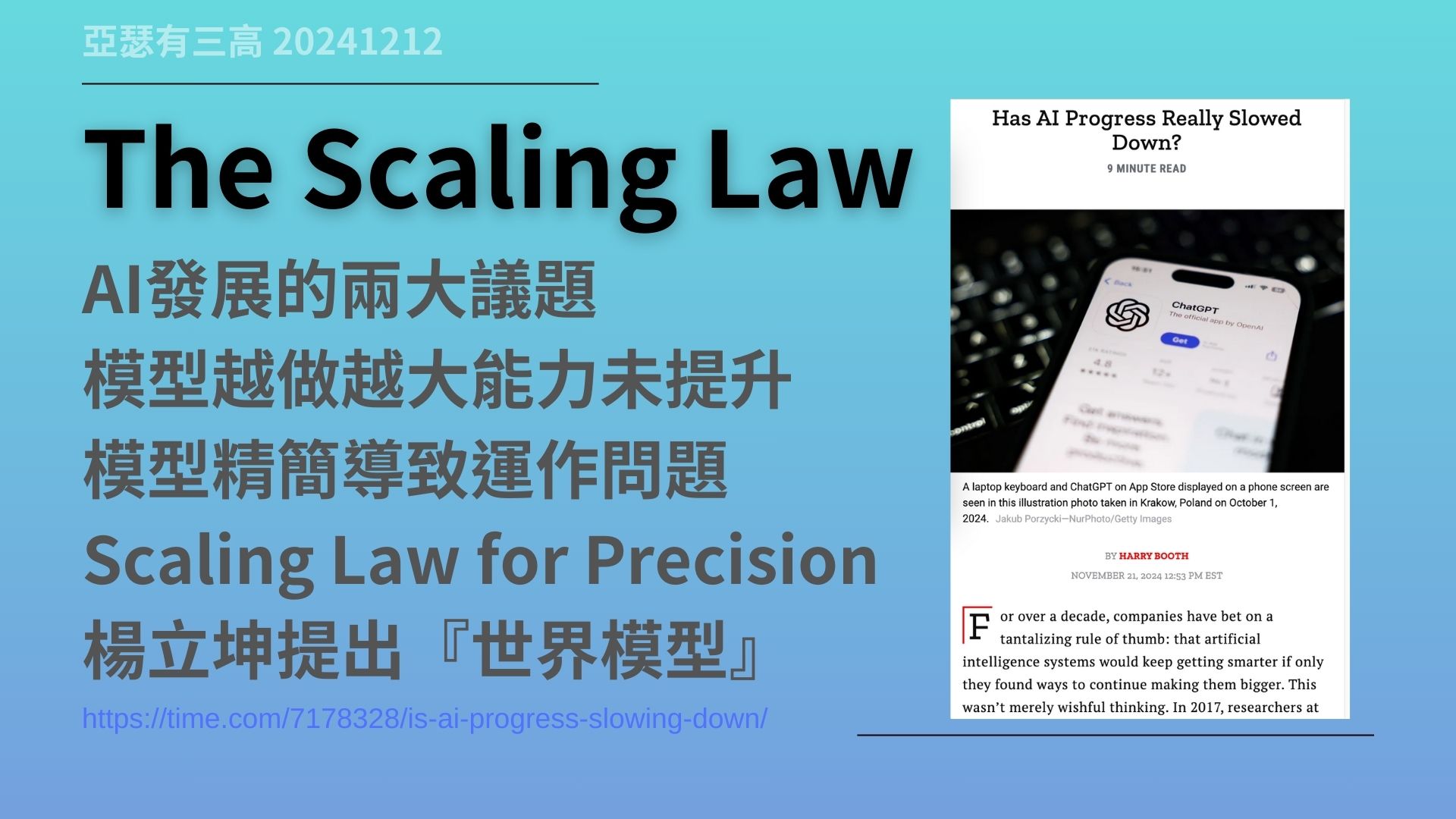

The Scaling Law。這個詞其實有點繞口,所以我們今天就不糾結名稱,只講它的意義。

前陣子AI圈子裡有兩個討論非常熱烈的議題。第一,語言模型越做越大,但能力卻沒有同步提升。第二,大家嘗試把大模型精簡化,模糊化以降低資源需求,但發現精簡太多後,模型根本跑不起來,性能大幅降低,準確度也明顯下降。

這兩個看似矛盾的議題,其實正是目前AI發展的核心挑戰,這就是Scaling Law所探討的重點。

今天,我們會從一篇非常有影響力的文章《Scaling Law for Precision》開始聊起。這篇文章討論了語言模型的擴展和精簡背後的核心邏輯,哪些方法有效,哪些無用。最後,我們還會談到Meta的楊立坤博士,他提出的「世界模型」概念,來看看AI未來的突破方向會是什麼。

簡單來說,我認為AI發展還早得很,沒有停滯。

模型越大提升越少

- 語言模型參數越來越大

- 性能提升遇到效益遞減

- 研究發現擴展效能有限

- 常識推理任務改進不明顯

- 擴大模型規模是否值得

https://artificialanalysis.ai/leaderboards/models

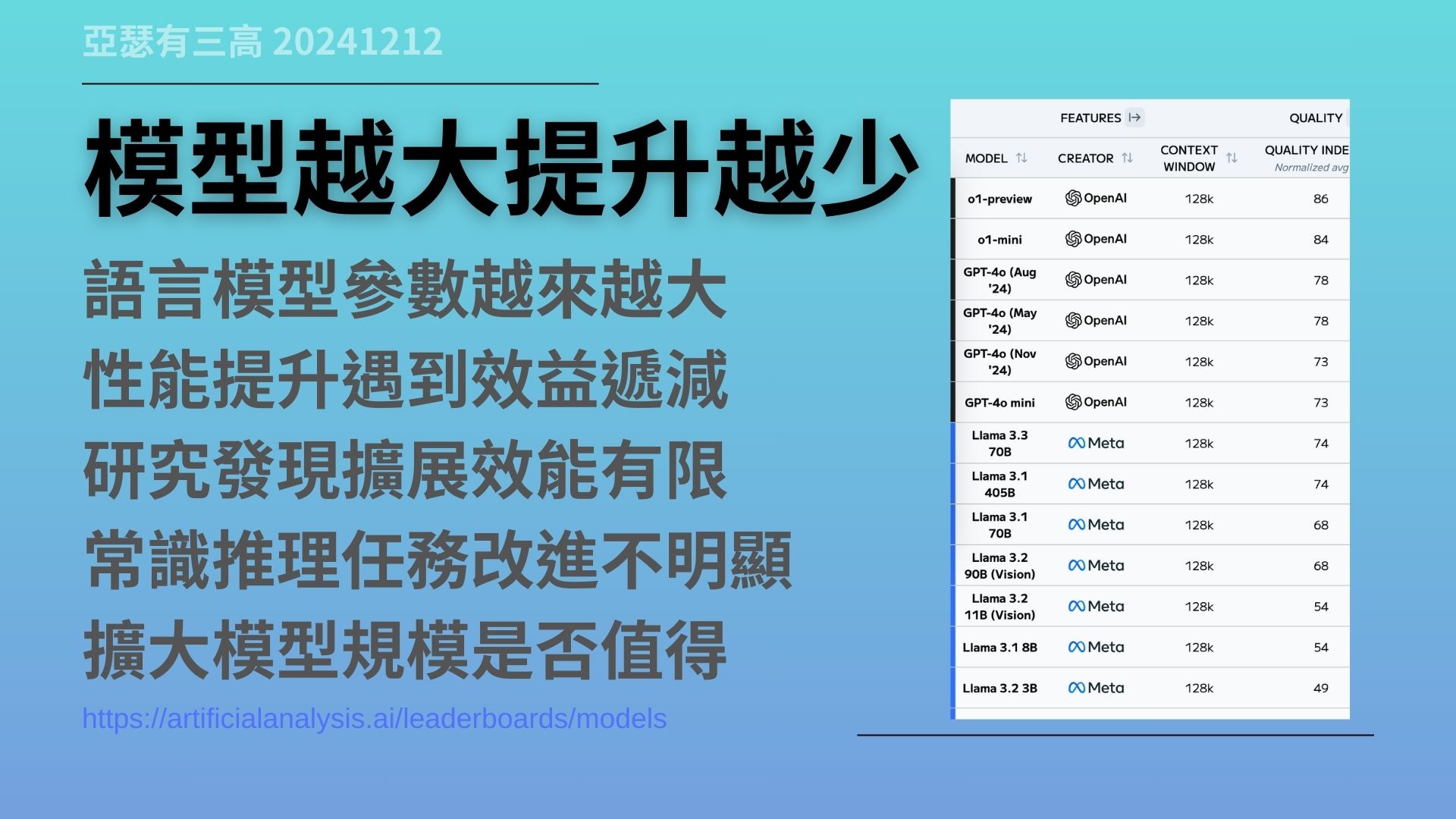

目前看起來的確是語言模型越做越大,參數越來越多,幾十億甚至數百億參數已經成為常態了。可是,照理說,這麼大的模型應該更聰明、更厲害,但實際情況卻不是這樣。

根據研究發現,或是我們自己嘗試也能感覺到,當模型參數從13B一路增長到200B時,性能的確有明顯提升。但是當參數進一步提升到405B甚至更大時,性能的增幅就開始變得非常有限,甚至還感覺不太出差別來。這就是我們所謂的「效益遞減」。

比如說,我們在一般的常識推理或語言邏輯任務上,研究者對許多大模型進行測試,結果發現,無論參數翻倍還是再翻倍,模型在這些任務上的表現幾乎沒有什麼太重大的改進。就像螢幕上的數字顯示,當模型的大小進入到405B時,它的表現其實反而沒有比較好。

這種情況讓人開始反思:我們投入這麼多資源去擴大模型規模,是真的有必要嗎?真的有用嗎?這正是目前大家最常討論的問題之一——AI是否遇到了發展的瓶頸。

精度降低可行嗎?

- 降低模型精度減少需求

- 16-bit到8-bit效率高影響小

- 進一步降到4-bit成果下降

- 低精度導致模型數據損失

- 適度精度平衡是關鍵

https://arxiv.org/abs/2411.04330

在大模型變大卻效果不佳的情況下,有人提出了另一種解法:降低模型的計算精度。簡單來說,就是用更少的位元數來處理數據,例如從16-bit降到8-bit,再降到4-bit。

最開始的時候,這個方法效果不錯。當模型從16-bit降到8-bit時,性能準確度幾乎沒有變,但是計算速度大幅提升,所需資源也明顯降低。

但問題是,當精度進一步降到4-bit甚至更低時,模型的表現開始出現問題。低精度的運算導致模型的細節和數據無法保留,結果是模型變得笨拙,甚至看不懂問題,亂回答。

簡單來說,降低精度就像我們戴上一副模糊的眼鏡。當度數稍微低一點時,還能勉強看清楚,但如果度數差太多,什麼都看不清,自然也無法做出正確判斷。

這個討論正是《Scaling Law for Precision》這篇論文的核心內容。結論是,降低精度的確是一種提升效率的方法,可以讓非常大的模型在比較小、比較簡單的硬體上也能運行。但是,這種提升效率的方法需要找到一個平衡點,不能降得太多。降得太多之後,也同樣沒有用。目前,我們已經到了很大的模型降低精度之後也不能再降的地步。

這時候,我們又回到前面所提到的問題——語言模型、AI模型是否真的遇到了瓶頸?

世界模型的概念

- 楊立坤提出世界模型構想

- AI需多模態數據進行訓練

- 文字無法涵蓋人類智慧

- 多模態提升AI理解能力

- 世界模型仿人類學習方式

https://ai.meta.com/blog/yann-lecun-advances-in-ai-research

那麼語言模型、AI模型到底還有沒有突破的可能性?這個時候我們就要來談一下Meta首席科學家楊立坤博士的看法。他提出了一個概念叫做「世界模型」。這個模型的概念是嘗試去解決目前純粹語言模型所遇到的瓶頸。

楊立坤博士認為語言模型的問題在於,它們太過依賴純文字的數據了。但是,人類的智慧並不是只有靠文字培養出來的。人類還會從圖片、聲音、影片,甚至觸覺、味覺去構成我們對世界的理解。

因此,他提出AI需要引入更多的多模態訓練,不能只靠文字來訓練,不能只靠文字的數據,還要依靠圖片、影片、聲音,甚至更多其他感測器或感知的數據。在這樣的世界模型裡面,可以讓AI能夠更好地去理解這個世界。不但能夠提升它的推理能力,還能讓AI有常識,甚至讓AI有邏輯,讓它更像人類的反應。

簡單地說,世界模型的重點就是要讓AI去模仿人類的多元學習環境。這是一個讓AI更進一步的非常重要的方向。

從電腦的發展看AI

- 30年前早期的電腦發展

- 每個進步都得更新硬體

- DOS加中文需要換電腦

- 播放MIDI MP3亦是

- AI未來發展更需要突破

https://www.wsj.com/tech/ai/yann-lecun-ai-meta-aa59e2f5

其實現在AI的發展,我們可以回頭看一下30年前電腦的發展。嘿,對,30年前,當時我小時候,任何一個小小的進步都可能需要換一台新的電腦,甚至要隔到一年、兩年之後,才有可能會出現跑得動的硬體。

舉個例子來說,像是我們最早期的DOS是沒有中文的,純英文。後來有了中文介面之後,大多數的電腦都需要換一台新的電腦,像那時候386的電腦就是這樣子的,為了中文就要換電腦。

接著,為了讓電腦能夠播放電子音樂,不是MP3喔,是MIDI而已喔,那個時候也得更新硬體、換電腦。甚至到了Windows95的初期,為了要能夠播放MP3,是的,為了要能夠播放MP3,又得換新的電腦,要換新的CPU,才跑得動MP3。

以現在的角度回去看當年,就會覺得當年的進步怎麼這麼慢啊!但是當時的每一步都非常重要。

AI也是一樣啊!我們現在才剛剛開始以文字為主的AI。未來還會有圖片、影片,甚至更多的東西需要給AI做訓練。甚至還會有聲音、味覺、觸覺,這些多模態的AI還需要開發。

這其中每一個AI的突破,都會讓現在的硬體完全跟不上,需要全面翻新。也就是說,每進步一點點,可能又要翻新一批硬體,又要更新一次新的製程。

換句話說,30年前的電腦不斷發展到現在,成為我們現在的模式,那麼AI才剛開始要起步而已。怎麼會停滯!還早的呢!

文字有限世界無限

- 語言模型發展遇到瓶頸

- 圖片影片訓練有更大潛力

- 多模態需更高算力支持

- 專注化AI模型更貼近需求

- AI未來發展空間仍巨大

回到結論,那AI的發展是不是就此停滯了呢?我的答案很簡單~那就是No!AI的發展沒有停滯,而是目前以文字為主的AI模型到了瓶頸。

接下來還有很多新的領域可以探索,像我們剛才說過的圖片識別、影片分析,甚至多模態的感知訓練,這些都是未來的重要方向。而這些領域裡面,對比於文字來說,它都需要更多的算力去支持,同時間也會帶來更多的可能性。

另外,我們看到更多專注化的AI模型,比如說它專門去識別語氣的、專門分析表情的、專門去感知人類情緒的,或是人類意圖的AI系統。而這些模型會讓AI變得更貼近人類,去幫我們解決一些實際上的問題,它會變得更專精。

所以說,AI的路並沒有走到盡頭,只是以文字為主的語言模型到了極限。那接下來圖片、影片的模型才剛剛才要開始,多模態的整合也剛剛正要開始。而這些新方向將帶領AI邁向下一個高峰。

所以AI的未來,還有很長很長的路要走,而我們現在,只是又站在一個新的起點上而已。未來來看我們現在那個起點,都是非常低的低點啊!

今天的分享就到這裡,感謝各位~拜!