Whisper AI語言模型 讓手機聽懂你 20240620,分享今天股市外,還要談WhisperAI語音模型,容會比較紮實一些,包括:AI第一步就是懂人話、替代傳統文字輸入、實際語音辨識測試、長對話需要3GB模、對話實際案例、未來應用前景、語音模型願景。

Whisper AI語言模型 影片

Whisper 讓手機聽懂你

嗨我是亞瑟我有三高

今天是2024年6月20號

除了分享今天股市外

還要談WhisperAI語音模型

讓手機聽懂你的重要功能

今天的內容會比較紮實一些

所以我會講快一點

20240620股市

- 昨天日盤收盤套利

- 獲利70多點

- 今日開盤進場套利

- 沒套利成功卻賺錢

- 不算成功的操作

今天是20240620

昨天日盤收盤

因為六月與七月的

台指期價差100點

有明顯的套利空間

所以在收盤結束前進場

夜盤3點15到3點半之間出場

大約賺70點

今天開盤發現台指期的點數

還是比台灣的指數低100點

也就是說應該

也有100點的套利空間

所以在8點45分到9點

開盤之間就進場準備賺價差

但實際操作起來

在9點半之前

台灣指數和台指期的

價差並沒有收斂

但這半小時還是賺到了錢

昨天下午的夜盤套利是成功的

但是今天上午的早盤套利是失敗的

雖然上午還是有賺

但原因是一開盤的上漲

而不是原本預期的套利

做錯了卻不小心賺到錢

這樣的情況不值得開心

在投資記錄上這筆應該算是做錯了

AI第一步就是懂人話

- AI第一步就是懂人話

- 語音辨識技術的進步

- Whisper模型效果好

接下來我們進入今天的主題

AI第一步就是語音辨識

目前有效地語音辨識系統

已經可以用很小的檔案跟需求

辨識出最基本的語言

或用很大的檔案跟系統需求

做出幾乎沒有錯誤的識別能力

這就是AIPC或是AI手機

最令人驚艷的地方

現在的語音辨識技術

已經可以做到幾乎百分之百

而且不需要網路

直接使用目前的手機

或電腦就可以實現

這樣的技術出自於OpenAI

而且目前還是免費的

這個模型的名字叫做Whisper

Whisper這個模型

我已經充分使用在

我的iPhone裡面

也使用在我的Mac電腦上

非常好用

最近我出片能這麼順利

也都是因為這個語音模型

在文字處理上給了我很大的幫助

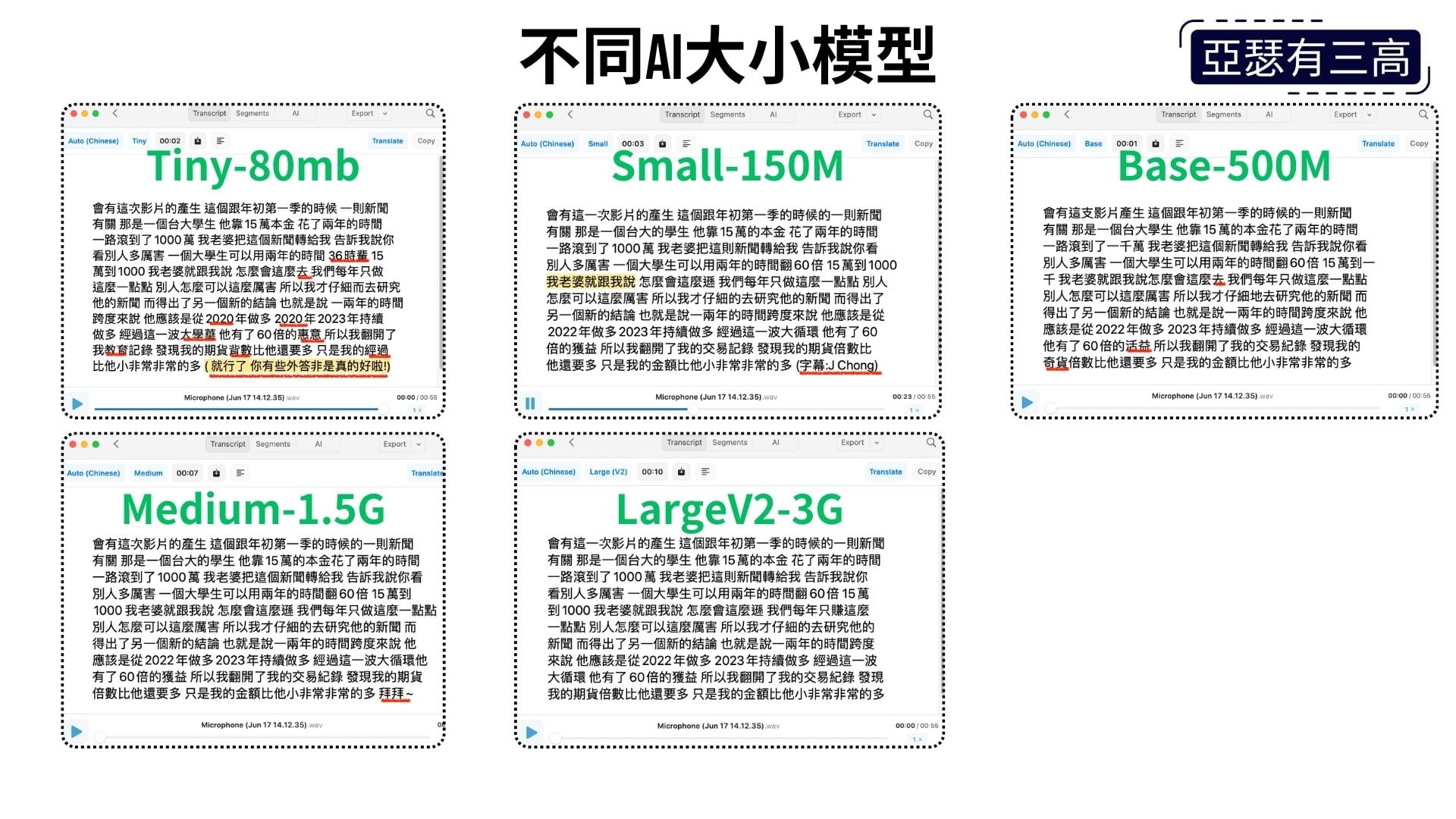

替代傳統文字輸入

- 替代傳統文字輸入

- 不同大小模組測試

- 辨識結果比較

- 500MB模型的意外

接下來將實際展示

這個模型的效果

並讓大家知道這個模型

一旦整合到我們的作業系統中

可以完全替代用輸入法

一字一字打字的困境

甚至改變許多

不同應用程式的使用情境

這段展示是一分鐘的語音片段

是之前在健身房裡

與ChatGPT聊天的內容

ChatGPT百分之百地

捕捉了我的話語

而我現在在家裡

重新念出這段語音

讓不同大小的Whisper模型

辨識看看效果如何

現在在畫面上可以看到

我已經展示了

80MB、150MB、500MB

1.5GB以及3GB

不同大小模型的辨識結果

當辨識錯誤時

我會用紅線標註

大家可以明顯發現

80MB的模型效果不佳

有時會變得亂七八糟

但令人驚訝的是

150MB的小模型已經能夠

完全正確地辨識這段語音

而更令人驚訝的是

剛剛沒有提到的

這一分鐘的語音

只花了幾秒鐘就辨識完畢

令人讚嘆

比較意外的是

500MB的辨識效果

竟然不如150MB

這可能是意外的情況

長對話需要3GB模型

- 長對話需要3GB模型

- 實際辨識的影片

- 指令辨識小模型即可

通常以一般講話的速度

和複雜的語助詞來說

需要到3GB的模型

才能完全辨識

螢幕上現在看到的

是我和Peggy聊天時的錄影片段

這段對話大約有五到十分鐘

使用3GB模型辨識之後

只出現了四處錯誤

其中一處錯誤是時間軸

另外三處是中文成語辨識不正確

除此之外幾乎全都正確

如果只是用來下指令

其實150MB或500MB的模型

已經足夠理解和執行我們的指令

未來應用前景

- 未來應用前景

- 目前設備的應用

- 本地辨識的優勢

OpenAI是微軟的親生兒子

所以在未來的Windows中

應該會內建Whisper模型

作為語音即時辨識的主要功能

微軟已經展示了

可以將44種語言

即時翻譯成英文字幕

26種語言即時翻譯成中文字幕

這技術已經非常成熟

很快就會整合到AIPC中

蘋果也和OpenAI合作

Whisper模型預計

也會進入蘋果手機與電腦

作為基本的AI語音系統功能

雖然蘋果說iPhone15Pro

以後的機型才能運行AI

但我使用自己的iPhone14Pro

搭配Whisper模型的APP

也能順利辨識中文速度不錯

在手機或電腦端進行本地辨識

可以節省ChatGPT伺服器的資源

需要更智慧的回答或資料處理時

才送到遠端大語言模型伺服器

用語音回答問題時

也可以將文字傳回手機

再由手機用AI轉成語音讀出

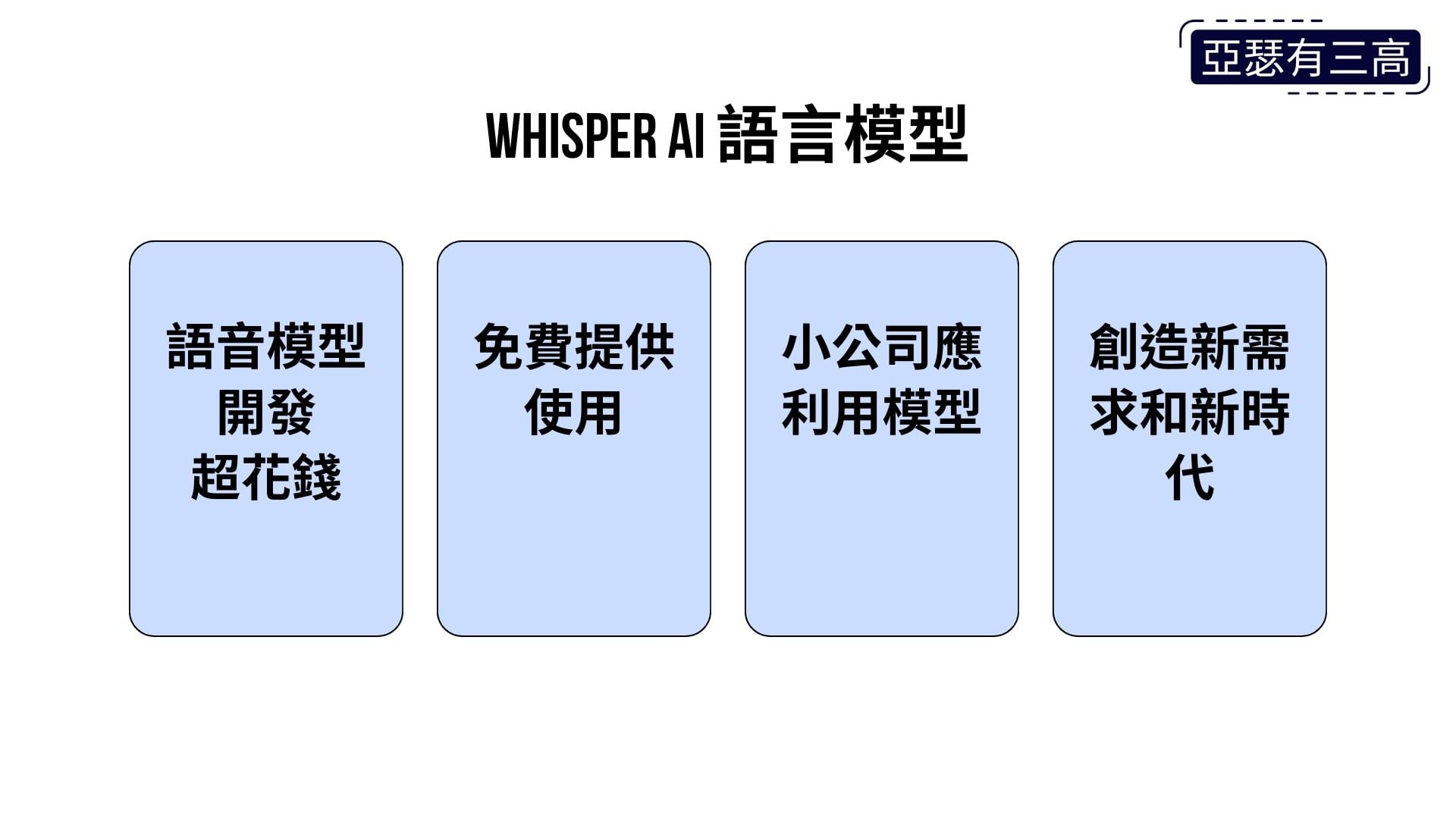

Whisper AI語言模型

- 語音模型開發超花錢

- 免費提供使用

- 小公司應利用模型

- 創造新需求和新時代

最後一點結語

語音模型開發

需要非常多的資金和時間

但這樣的模型

免費提供給大家使用

這呼應前幾集提到的

大模型最終往往是免費公開的

身為小公司不一定要參與

這些巨頭的大型模型競爭

只要做好技術應用角色

利用他們開發的語音模型

製造語音辨識晶片

並在各種電器中

實現新需求和新時代

所以最後一句

聯發科發哥加油

下次來談壓寶聯發科的過程~掰