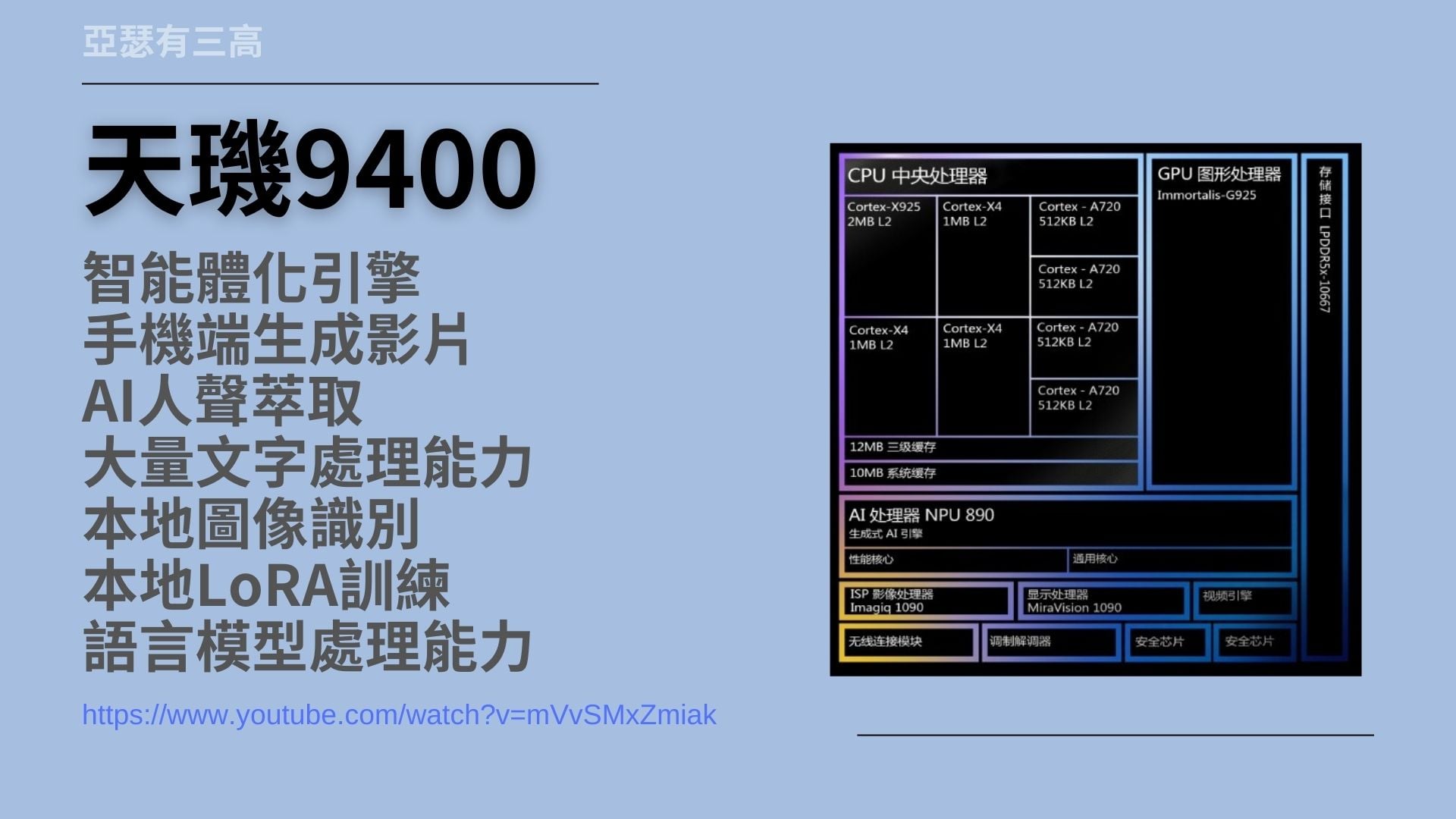

天璣9400 聯發科AI晶片 20241011,聯發科發表了其最新的天璣9400 AI晶片,標誌著台灣在AI領域的重要突破。影片中詳述了天璣9400的多項技術亮點,包括AI智能體化引擎、手機端生成影片、本地LORA訓練及大模型的支持等,展現了高度智能化和隱私保護。

天璣9400 聯發科AI晶片 影片

天璣9400 聯發科AI晶片

- 智能體化引擎

- 手機端生成影片

- AI人聲萃取

- 大量文字處理能力

- 本地圖像識別

- 本地LoRA訓練

- 語言模型處理能力

嗨我是亞瑟我有三高

今天要來談天璣9400

也就是聯發科的AI晶片發表會

雖然離發表已經過兩三天了

但是越看越覺得這是我們台灣一個非常重要的發展

也是AI史上一個非常重要的發展

所以這個不得不來提

今天整支影片會圍繞在天璣9400的發布會

下面的連結附上的是YouTube上的連結

是聯發科自己提供的

那這一個發布會總共有兩個多小時

說句實話 可怕的無聊跟允長

之前我是透過媒體看了一些片段

後來發現真的太重要了

所以不得不把它看完

所以我耐著性子看完它

並且為各位做出AI部分的解說

節錄重要的部分

下面的每一個章節附上的連結都是那一個時間點

所以點進去就可以進到我所提的那個點上

因為連結不好放所以連結在我的官網

請連去官網喔

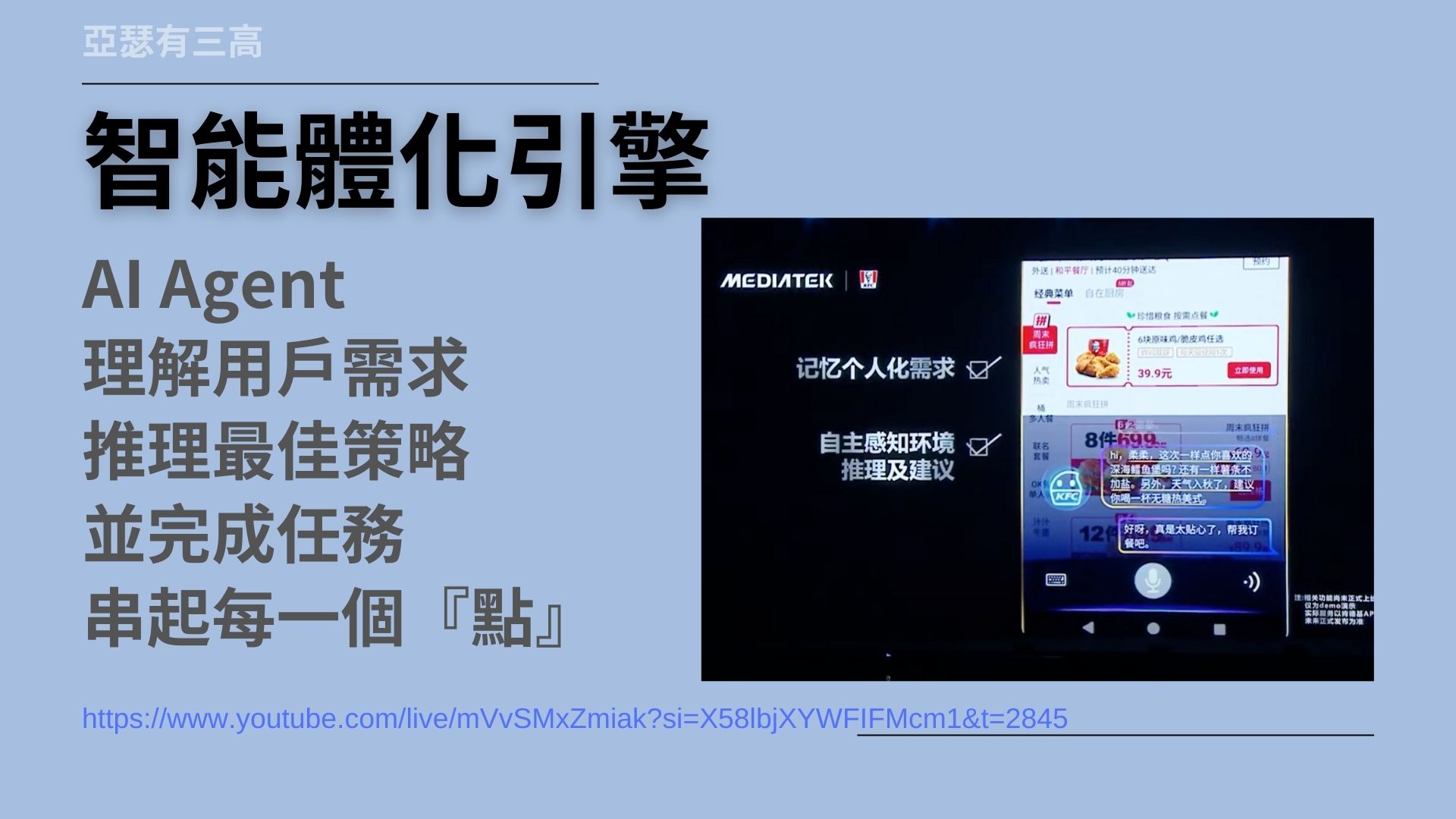

智能體化引擎

- AI Agent

- 理解用戶需求

- 推理最佳策略

- 並完成任務

- 串起每一個『點』

這個發表會齁

扯了五十幾分鐘之後才終於進到主題

那就是AI的智能體化引擎

聽到這個字我也傻了

什麼是智能體化引擎說穿了啦

就是之前聯發科在傳出的發哥嘛

以目前的名詞來說

它就是AI agent

AI agent它本身是可以去理解用戶的需求

並且推測最佳的策略

然後完成你想要給他的任務

目前我們所有的節點都還沒有完全AI化

每一個步驟每一個地方

它都可能會這邊一個點那邊一個點

有些有智能化的有些沒有

有些是AI有些不是

有些甚至還是文字化的東西

或者是我們跟手機講話也是用口語的方式

所以我們會需要一個AI代理人

來幫我們串起所有東西

去執行我們想要執行的東西

所以智能體化引擎

那就是聯發科終於把AI agent實作出來了

這真的是世界首創喔

這是世界首創喔

雖然Copilot在企業那邊也有一些實體上的應用

雖然OpenAI也有一些展示

但是如果說聯發科的這樣東西

馬上就要在幾天之後發表在手機上面就要有的話

哇那聯發科可是首發喔

AI agent再過幾天可能就會落地喔

希望他沒有吹牛啊

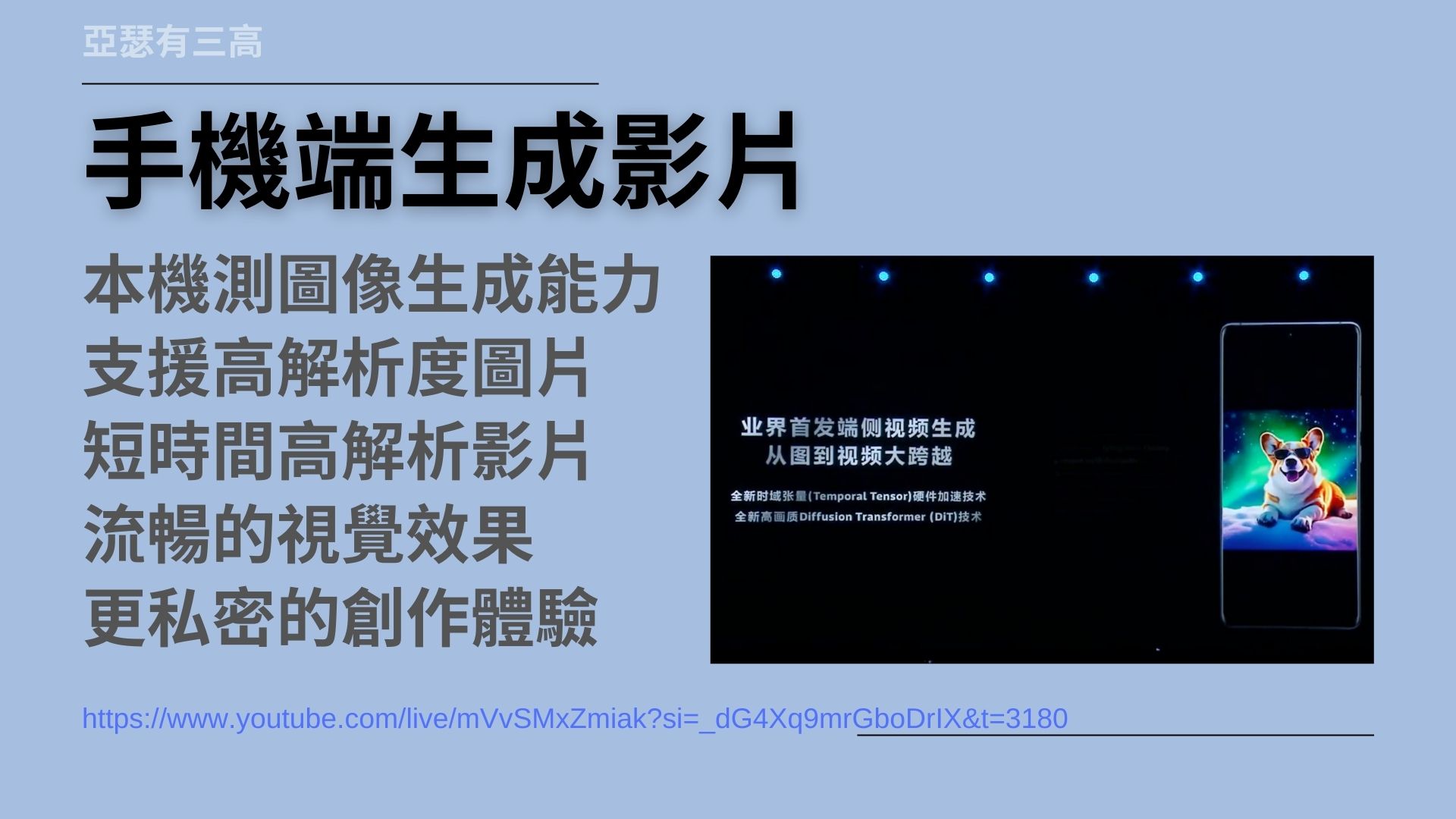

手機端生成影片

- 本機測圖像生成能力

- 支援高解析度圖片

- 短時間高解析影片

- 流暢的視覺效果

- 更私密的創作體驗

接下來聯發科提到在手機端生成影片

如果你看影片他會一直發現他講端端端

端這個字以台灣人角度來講的話他就是本機

他可以在本機這邊產生出圖像的生成能力

非常厲害

而且我看他的展示範例

已經可以支援高解析度的照片

高解析度的影片

而且他還可以生成短時間的高解析度的影片

狀況也非常的流暢

那這個部分其實是非常重要的事情

因為現在你想要創造什麼智能化的影片

或是用你自己的東西去產生一些影片的話呢

你勢必會把你的資料傳到網路上面去

如果說我傳到我的臉去別人的網站上

那換句話說之後所有的人都會拿我亞瑟的臉做創作

哇那還得了對吧

所以手機端就可以生成影片生成照片

那麼就可以讓你的創作

會控制在你自己的範圍裡面

而不會被其他人拿去

另外你要用客戶的資料或不方便公佈的資料

來做一些AI的應用的話呢

你也會需要使用本地端的影片生成內容

所以這個很重要

從這邊可以延伸出

AI世界的網路色情可能也因此而大大改變

這個部分呢趁著我現在還有幾百人訂閱而已

不在乎流量的時候我們後面來寫一篇

關於AI時代網黃可能會有怎樣的改變

其實現在已經開始了呢

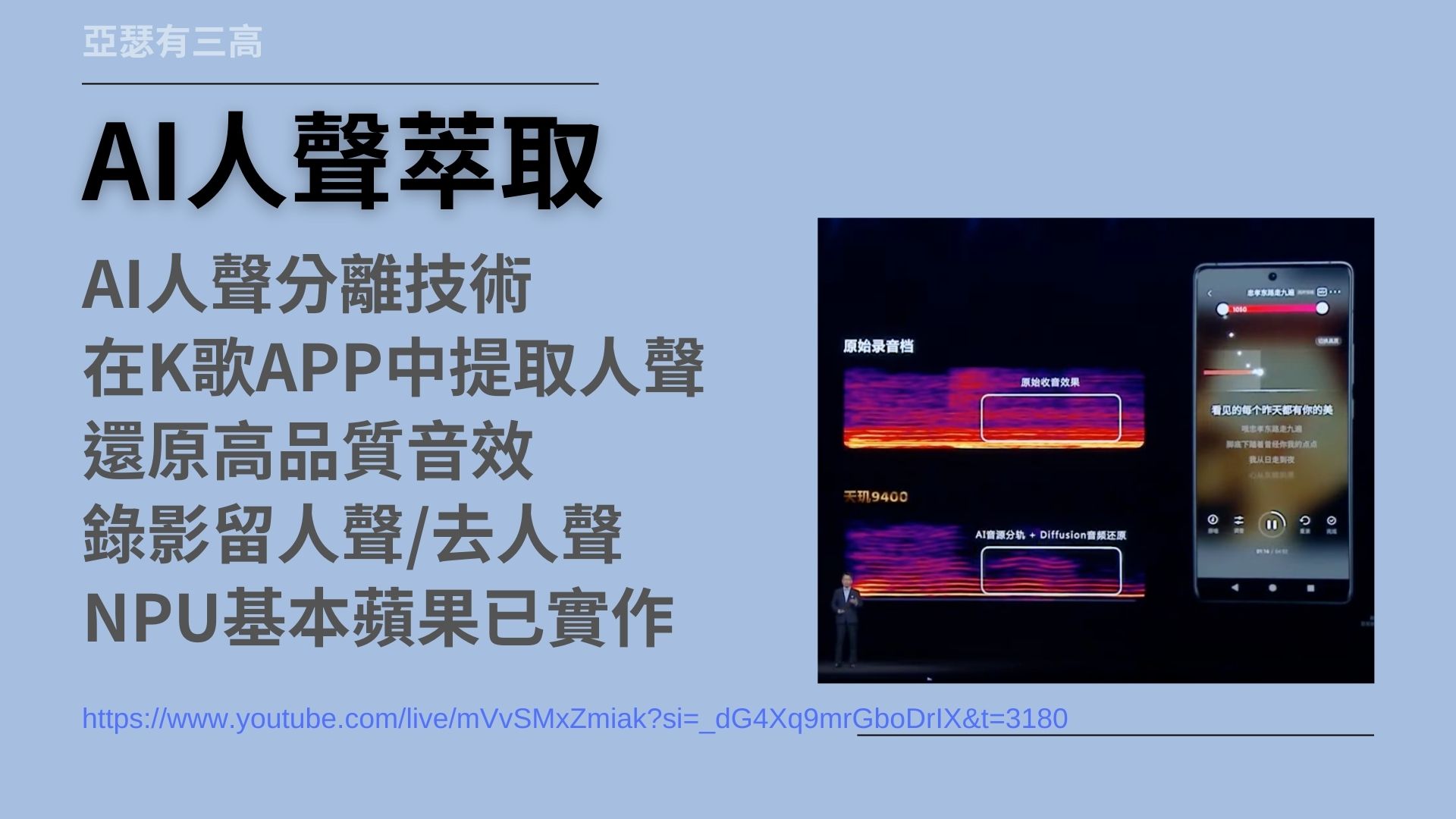

AI人聲萃取

- AI人聲分離技術

- 在K歌APP中提取人聲

- 還原高品質音效

- 錄影留人聲/去人聲

- NPU基本蘋果已實作

聯發科用很短的時間提了一個新技術

那就是AI人聲萃取

他可以用AI的方式把人聲從其他聲音中提取出來

例如說他可以在K歌的APP裡面呢

就可以提取人聲

即使用很差的手機

然後沒有麥克風他也可以錄出不錯的聲音

因為他可以把背景音消掉

甚至是有時候你也可以把人聲消掉

只留背景音就好了

基本上這個功能在蘋果這邊已經實作很久了

Final Cut Pro早就可以做這件事情了

那最近剪映好像也開始有這個功能了

所以這不算太厲害的功能

但是這個功能很好用

Android終於也可以有這個功能了

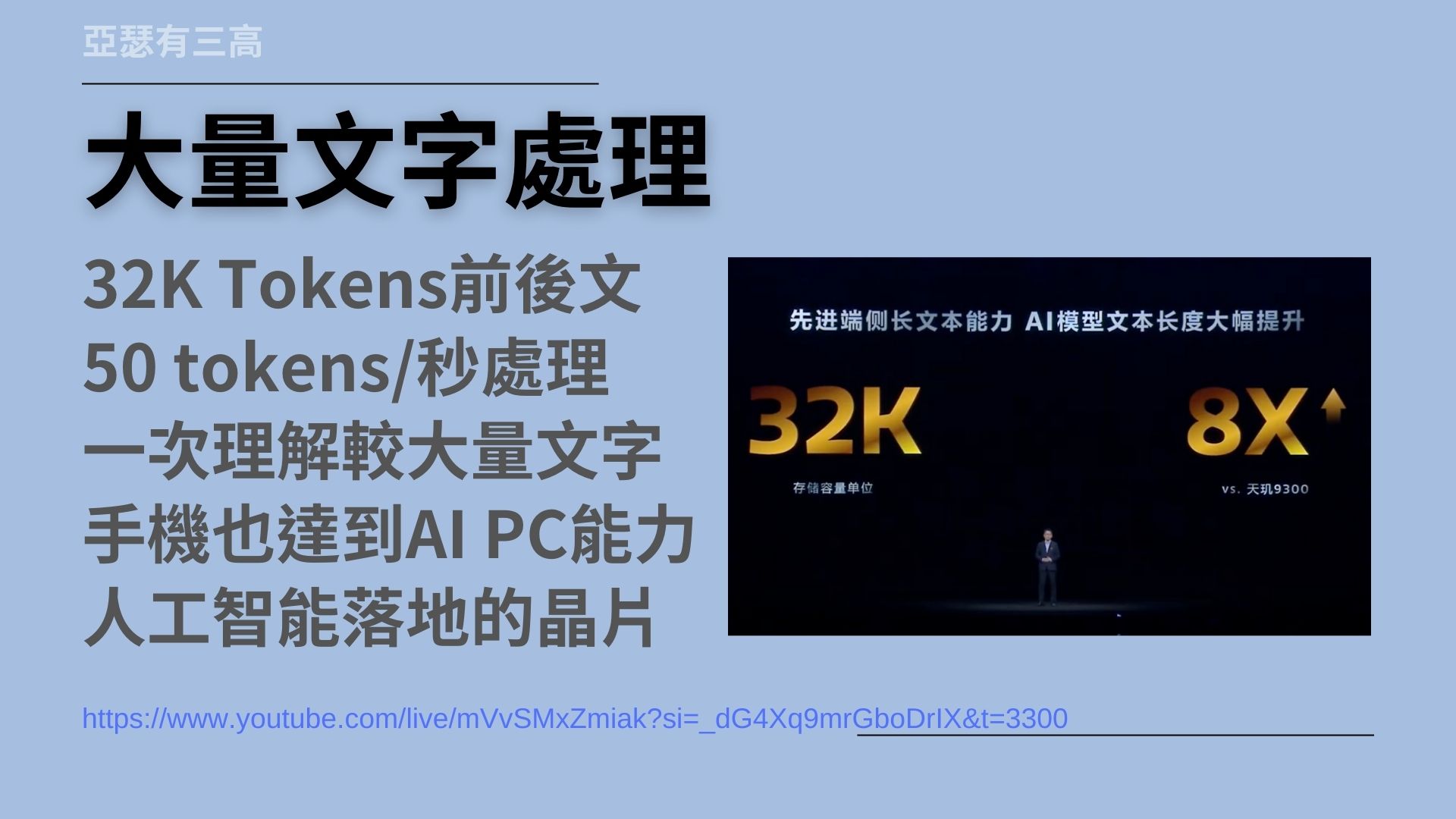

大量文字處理

- 32K Tokens前後文

- 50 tokens/秒處理

- 一次理解較大量文字

- 手機也達到AI PC能力

- 人工智能落地的晶片

另外提到的是大量的文字處理

這個部分算是非常前進的功能了

天璣9400已經可以處理32K Token的前後文

這意味的事情是

他可以把一本書例如三萬兩千字

他可能五分之一或十分之一的內容先讀進去

然後幫你做處理

你可以把一本書分段讀取

他就可以分段的把一本書幫你解析完畢

哇這算是很厲害的事情了

因為手機可以處理這些事情算是非常厲害的

目前OpenAI也不過就是可以處理差不多這樣子的能耐而已

另外他每秒也可以出50 Token的字元

也就是說他每秒可以吐出50個字

可以這樣去意會他

也就是他每秒產生文字的能力

應該和Chad GPT-4o的速度跟能力差不多

沒想到到這個時候手機也可以達到AI PC的能力了

如果這個事情是成真的話

那麼人工智能應該就從這個晶片開始落地

終於可以實現了

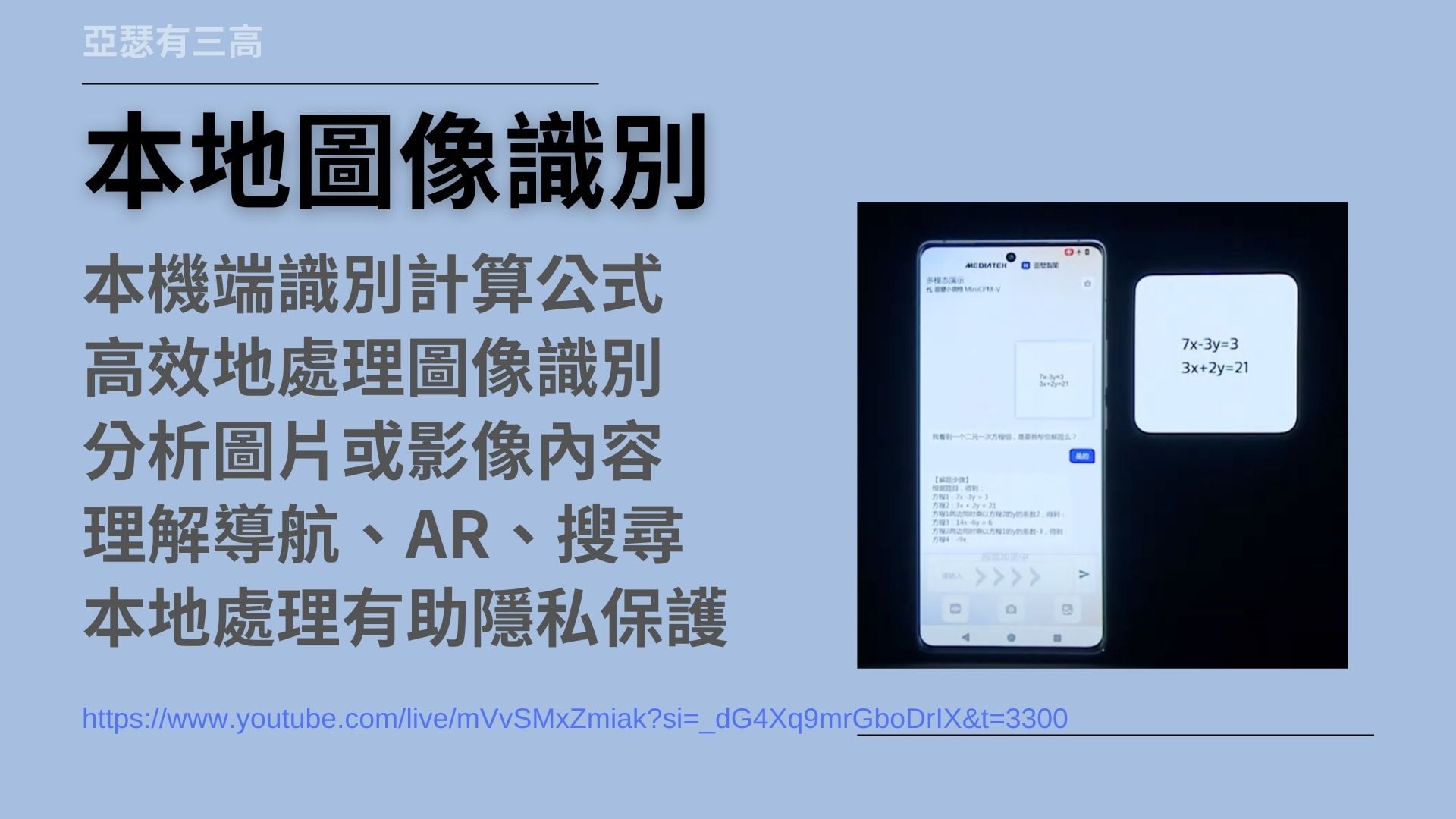

本地圖像識別

- 本機端識別計算公式

- 高效地處理圖像識別

- 分析圖片或影像內容

- 理解導航、AR、搜尋

- 本地處理有助隱私保護

另外也提到了本地圖像識別的功能

在影片裡面

他拿了一個公式然後丟給聯發科的機器

去識別這個公式 然後去幫他做計算

並且告訴他他要怎麼計算的

以這個部分就可以證明一件事情

聯發科已經可以做到用手機本身的能力

去識別公式、識別圖片或影像內容了

我們可以往下延伸

以後例如說導航你也可以用這個方式去識別

AR或是搜尋也都可以用這個方式去做識別

本地圖片識別他對保護隱私有非常大的功用

我舉一個我自己的例子來說好了

寫一堆消費紀錄

這個時候我只要拿我的手機拍一下消費紀錄

我就可以把用手寫的那些文字全部轉成電子資訊

全部送到我的伺服器裡面存起來

這個功能本地的圖像識別將會是我們第一步

終於可以把紙質文件變成電子文件的AI自動化的第一步

這算是在終端這邊非常大的一個突破喔

本地LoRA訓練

- 端側進行LoRA訓練

- 訓練自己的模型

- 個人內容、頭像與表情

- 隱私安全、個人數據

- 定制自己的分身與配音

再來是本地LORA訓練

如果說沒有在關注AI的人

或是關注沒有很認真的的人

聽到LORA應該傻了吧這是什麼東西

簡單說就是你可以把自己的圖片、聲音

或是把自己的資料、文字丟給你的手機

讓你的手機去幫你做訓練

所以可以訓練出自己的內容、自己的頭像、自己的表情

這意味著你的隱私、你的內容、你個人的資料

就不用送到網路上面去

最簡單的例子你就可以自訂自己的分身

自己的配音或自己的導情包

那我們再延伸一點

像我們剛才說的網黃

這下子是不是可以自訂更多的東西出來了

舉實際上的例子

像我是經營指甲店的

我就可以把我客戶的照片或客戶處理的資料

全部都送給AI去讓他做訓練

這個時候AI就可以得知

什麼樣的客戶大概需要多久的時間

什麼樣的客戶大概需要怎麼樣的處理

AI就可以在線上幫我回答客戶的問題了

是不是很厲害

語言模型運作

- 3B&7B AI模型順暢

- 13B 模型可以執行

- Gemini nano LLM

- 發哥的7B Breeze

- 也許會晶片綁軟體

接下來我們走到最後一個

那就是語言模型的運作

其實我覺得這一整個說明會裡面

最重要的這一段就是這一段了

這一段很可惜竟然不是由聯發科自己講的

它是由 VIVO 的人來講的

目前用天璣 9400 已經可以順暢執行

3B 跟 7B 的 AI 模型

也就是說像是 Gemini Nano 的 LLM

它大概是 3B 左右 它可以順暢執行

那聯發科自己的發哥 7B Breeze

這個應該也可以順暢執行

比較厲害一點點的 13B 模型 也可以啟動

它沒有說順暢 它說可以啟動

因為我想應該也是

因為 13B 的模型

可能會需要大約 8G 的記憶體

那麼以目前手機最大 16G 的記憶體來說

可能會不夠

以目前公告的數據跟同行的反應來看

看起來這一年 就是明年的 AI 手機

可能會以 7B 的模型為主

如果又對比聯發科跟 Google

給出的能耐的話

可以發現 Google 目前能耐有點弱

聯發科走得比較先進

再參考三星可能也要配 天璣 9400 這顆晶片的話

接下來各家重要廠商

都會搭配聯發科的這一顆 CPU

綁上聯發科自己的 AI Agent

這可以在本地端執行 AI

這樣才可以有機會和蘋果對打

依照 Android 系統先發的習慣

他們這個時候應該早就要有先發軍

領先蘋果先發出一些

很特別的應用出來了吧

不然不是給蘋果打假的嗎

我對聯發科發表會的感想就講到這邊

當然啦 它總共有兩個小時

所以還是有很多零零雜雜的東西

如果各位有興趣的話

也可以點進去看一下

了解一下 全世界最厲害的 IC Design

怎麼可以把發表會做得這麼無聊

到這邊~掰