GTC 大會壓軸 AI 教父楊立坤 語言模型走錯方向 20250328,楊立坤在 GTC 對談中指出:語言模型無法處理物理連續性,未來 AI 必須依賴世界模型與 JEPA 架構。本篇整理完整內容,解析從推理方式到硬體挑戰的七大核心議題。

AI 教父楊立坤 語言模型走錯方向 影片

楊立坤在GTC最後的對談當中

竟然說他不認同黃仁勳

語言模型無法處理物理世界

未來必須依靠世界模型以及JEPA架構

這一次真的是好好打臉了黃仁勳

我是亞瑟我有三高

每個禮拜一到每個禮拜五

我都會日更這個頻道

去分享學到的點點滴滴

今天我們來看一下楊立坤

在GTC大會上到底講了什麼

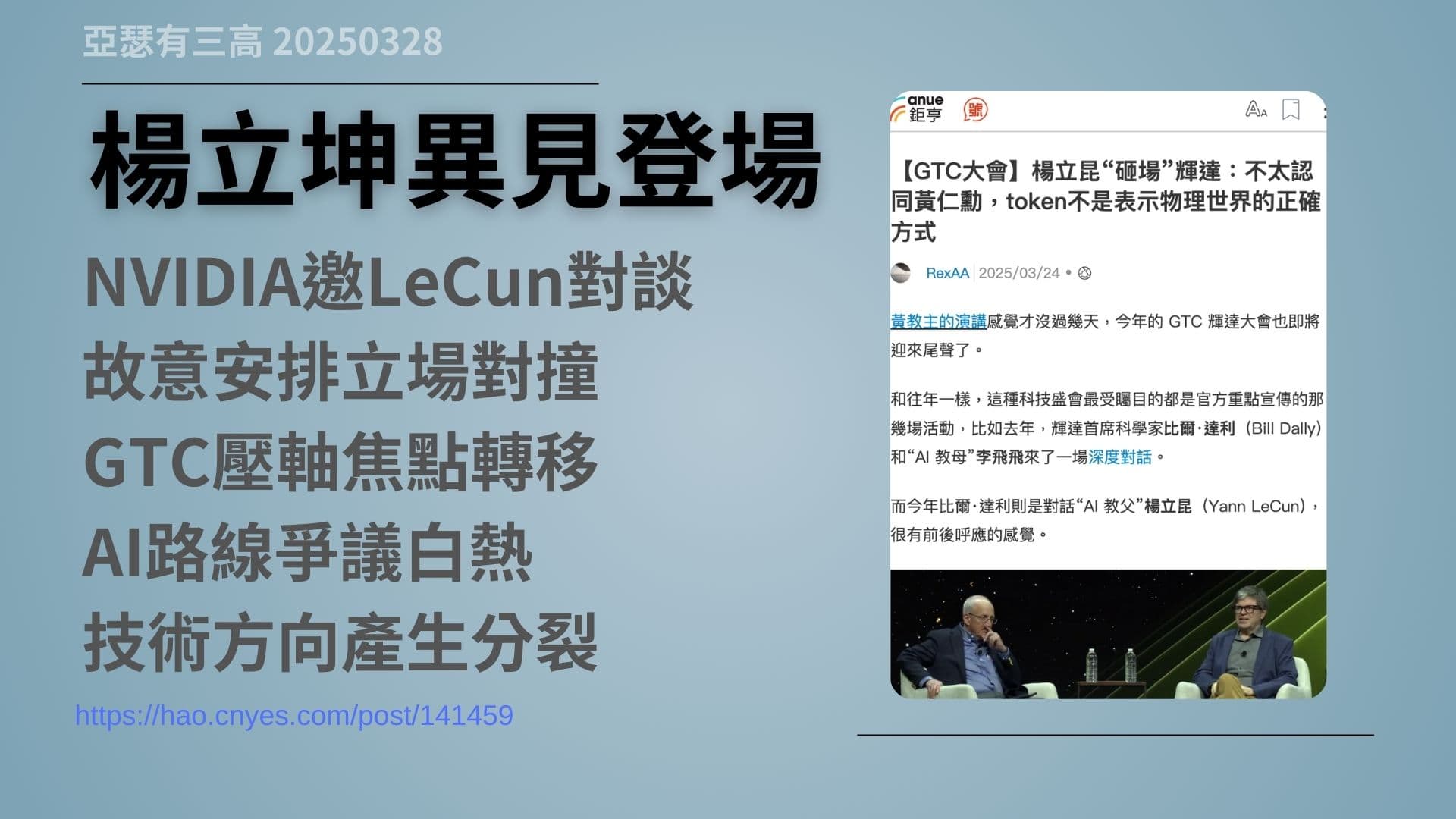

楊立坤異見登場

- NVIDIA邀LeCun對談

- 故意安排立場對撞

- GTC壓軸焦點轉移

- AI路線爭議白熱

- 技術方向產生分裂

https://hao.cnyes.com/post/141459

AI的智力不如貓 楊立昆

https://arthur3highs.com/1903

AI算力 與 世界模型 20250219

https://arthur3highs.com/2848

今年 GTC 大會接近尾聲的時候,最引人注目的,其實不是黃仁勳的演講,而是一場刻意安排的訪談。由 NVIDIA 的首席科學家 Bill Dally 親自主持,對談的對象則是來自 Meta,被稱為 AI 教父的楊立坤。這是一場觀點對立、公開交鋒的對談。

楊立坤多年來一直批評,主流大語言模型的走向。無論是他對自回歸架構的否定,還是對算力驅動、token 式推理方式的質疑,立場都非常明確。而這場對談也不只是針對模型本身,還深入到了 AI 未來的發展方向——包括推理方式、記憶機制、世界模型的建構邏輯,甚至延伸到光學計算、量子運算這些技術的實際可行性。

在這支影片裡,我會把這場訪談內容分成七個段落,一一解析楊立坤對現行 AI 路線的挑戰、他主張的替代方案,以及這些觀點對未來產業可能帶來的影響。

在開始之前,我先假設大家對楊立坤,已經有一定程度的認識了。因為我們頻道其實已經講過他很多次了,包括他說的「AI 智力還不如一隻貓」,還有「世界模型」的概念。建議大家如果還不熟,可以先回去看那幾支影片,這邊我就不重複了。

最後提醒一下,我的立場是比較偏向楊立坤這一派的。

語言模型無理解

- LLM靠預測無理解

- 推理能力過於表層

- 資料算力只是疊加

- token空間限制明顯

- LLM難規劃真行動

https://hao.cnyes.com/post/134712

楊立坤一開場就講得很直接:語言模型頂多只能,在文字層面做些小幅度的改進,但它的基本原理,其實從來沒有改變。到現在還是靠大量資料、大量算力,堆出一個龐大的結構,一層一層往上疊,然後在「預測下一個字」這件事情上不斷優化。

但問題來了,這種離散式 token 的預測方法,沒辦法處理真實世界的連續性,特別是像空間、動作、因果這一類複雜的概念。語言模型所謂的推理,其實只是隨機產生大量的文字,再挑出一個看起來最合理的組合而已。

在楊立坤看來,這根本不算智慧,只是統計上的花拳繡腿。語言模型這幾年的進步,很多其實也只是一直在邊邊角角上修修補補,離真正能夠理解世界的智能系統,還差得非常遠。

我支持楊立坤博士的觀點。最近 Google 推出的 Gemma 3 模型,其實就提供了一個很好的例子。Gemma 3 把多餘的訓練資料和 token 規模縮減,只留下核心的語言理解能力,結果 12B 的模型就能做出非常出色的回答。

也就是說也許語言模型,這幾年的走法真的有問題。如果我們能把「理解世界」的能力導入語言模型,某種程度上,這正是 Gemma 3 現在嘗試探索的方向。

世界模型是關鍵

- 人腦靠內建模型

- AI需理解物理世界

- LLM無法建構場景

- 像素預測效果極差

- 抽象表示才是重點

https://ai.meta.com/blog/v-jepa-yann-lecun-ai-model-video-joint-embedding-predictive-architecture

楊立坤認為,人類真正的認知能力,是來自「世界模型」。這不是語言,而是一種在腦中模擬整個物理世界的能力。我們可以預測物體會怎麼移動、理解力學的作用,甚至在還沒動作之前,就已經模擬出接下來會發生什麼事。

這種推理,不是靠文字來完成的,而是在一個抽象的內部空間裡,直接模擬出來。相比之下,大語言模型只是預測下一個字是什麼,它的理解完全停留在語言的表層,對現實世界完全沒有建構能力。

你可以讓語言模型模擬講話,但你不會期待它真的懂「杯子為什麼會從桌上掉下來」。因為它根本沒有世界觀,也沒有模擬物理因果的能力。

所以楊立坤提出了 JEPA,也就是「聯合嵌入預測架構」,作為替代方案。他主張AI 應該從觀察中,學會抽象的理解與表示,再用這些理解去預測未來、規劃行動,而不是一再重建畫面,或只是重新排列語句。

這也是楊立坤最核心的批判:我們太早停在語言層次,結果忽略了更根本的問題:AI 應該要先學會像貓一樣走路,而不是急著學會說話。

拒絕AGI迷思

- AGI概念太神話

- 人類智能本不通用

- AMI才是務實方向

- 動物式規劃更重要

- 暴力搜尋效率低落

在對談中楊立坤表態,他不喜歡使用「AGI」這個詞。他認為通用人工智慧這個概念過於美好,實際上人類的智能,本身就是高度分工與專業化的。因此追求這種模糊的理想,不如推動更具體的方向:高級機器智能(Advanced Machine Intelligence)。

AMI 的核心在於,讓 AI 能夠像貓一樣理解環境、計算風險、做出決策。舉例來說,一隻貓在跳到書架之前,會在腦中模擬出高度、動作以及可能的風險。這個過程完全不是依靠語言式的推理,而是一種基於感知的預測與規劃。

反觀目前的語言模型,只是生成大量 token,再從中選出看起來最合理的結果。這種方式,就像不會寫程式的人亂拼一堆程式碼,或像不會說話的人隨便湊一句話,最終努力湊出一段能用的內容。從運算的角度來看,這種做法效率極低,也難以運用到更複雜的任務。

楊立坤認為,真正的推理應該在抽象空間中進行,而不是停留在語言的表層。真正的 AMI 需要像動物,擁有生物的直覺與規劃能力,而不是只會記單字、補語句的鸚鵡模型。

其實這個世界不是真的都在發展語言模型,Tesla或是nVidia的自動駕駛,其實就在走世界模型的概念,去塑造真正理解人類世界的運作,好讓自動駕駛能夠成真。

AI輔助提升人類

- AI應提升人能力

- 醫療交通已有成果

- 生成式AI非主力

- 感知系統才是核心

- 部署比建模更困難

楊立坤認為,AI 真正有價值的地方,不在於它能不能模仿人類說話,而在於它能不能提升人類的效率與能力。

像是醫療影像判讀、藥物設計、MRI 的快速重建,這些領域 AI 早就已經實際部署,創造了具體的價值。而這些應用的核心,不是語言生成,而是感知、判斷與決策。

目前的自動駕駛技術,是靠感測器資料,與即時反應的 AI 模組完成的。這些系統最大的挑戰,是能不能準確穩定,並且可靠地整合進真實世界,這比很多人想像的要困難得多。

楊立坤強調,大多數真正可實用的 AI,其實並不是語言模型,而是感知型、反應型的架構,用來協助人類完成特定的任務。

因此未來值得投入資源的,不是那些試圖取代人類、模仿語言的系統,而是那些能夠實質強化人類能力、讓人類變得更強的工具與架構。

這一點其實也呼應了,戴倫·艾賽默魯教授的觀點:目前的 AI,還沒有真正影響整個社會的生產力。我們真正該推動的,是那些能夠普遍造福人類的 AI 技術。

開源與多樣性

- AI不能一言堂

- 模型需文化多樣

- 開源降低集中壟斷

- LLaMA鼓勵全球參與

- 民主社會需AI開放

https://www.linkedin.com/pulse/metas-llama-open-source-strategy-ai-subodh-kumar-adzxf

隨著 AI 助手越來越深入我們的日常生活,楊立坤也提出了一個非常關鍵的警告:我們不能接受,所有人都在使用同一種語言模型、接受同一種文化偏見的 AI,這關係到民主與多樣性的根本挑戰。

未來每個人都會有 AI 助手,但不應該只是由矽谷提供的選項。我們需要的是能說各種語言、理解不同文化背景,甚至內建不同價值觀的模型。

多樣性只有透過開源,才能實現更多元的發展。Meta 開源 LLaMA 模型,就是要讓全球各地的研究者,都能夠在這個平台上,發展出屬於自己語言、自己文化的 AI 系統。

我非常支持語言模型的開源,因為可以廣納全球更多的想法與智慧,把人類所有的文化、語言、觀點通通融入進來,這是一種文明整合的力量。當語言模型夠大之後,能夠同時包容所有文化、語言,變成一種「全知型」的語言系統。

但也正因如此,我認為未來人類還是會走向,由少數超級語言模型主導的世界,觀點的一致性,也許遲早會成為現實。就像今天我們幾乎所有人都用 Meta、Gmail、Google,一樣的結果,很可能再次發生在 AI 身上。

推理更需算力

- 推理比訓練更吃資源

- System2需高算力支撐

- 光學量子實用性有限

- 記憶體內運算更實際

- JEPA需新硬體支援

https://hao.cnyes.com/post/140913

楊立坤指出,當我們談到真正的「推理能力」時,訓練成本其實不是最大的問題,真正燒資源的是推論的運行。

像 JEPA 這類模型,需要在抽象空間中,模擬出各種可能的路徑,去預測未來會發生的不同狀況。這就很像神經科學中提到的 System 1 和 System 2:S1 是直覺性的反應,就像現在的語言模型;而 S2 則是需要經過深思熟慮的結果,而這一層級的運算,消耗的資源會遠高於現在的 LLM。

當 AI 從「生成文字」升級到「模擬現實」,推理所需的算力會以倍數增加。世界模型的運作,不是生成幾段話而已,而是持續計算整個環境變化的可能性。

楊立坤也直白地說,目前熱門的替代性技術,像是光學運算、量子計算、類神經晶片,目前還太理論化,要克服的挑戰太多,短期內很難落地。

他反而認為 GPU 搭配「記憶體內運算」(PIM),更可能支撐 AI 推理的發展,因為它既有延續性,又能改善能源效率。所以楊立坤強調,未來真正的瓶頸,可能不是模型怎麼設計,而是硬體能不能跟上。

在錄這支影片的時候,全世界的 AI 股正好在大跌,大家開始懷疑 AI 伺服器是不是需求會下降。但我的看法剛好相反,未來的運算需求只會更高。十倍、百倍、甚至千倍的算力,可能都還不夠。楊立坤基本上也說了同樣的事。

靠開源共創世界

- 每人都將擁有助手

- AI需在地語言文化

- 開源是唯一可行路

- 全球分散式共同訓練

- 進化非爆炸式發展

https://time.com/6694432/yann-lecun-meta-ai-interview

在訪談的最後,楊立坤提出了一個具體、務實的未來想像:未來每個人都會擁有自己的 AI 助手,隨時協助你工作、學習、規劃,甚至陪伴你。這不是 AI 奴役人類,而是人類成為 AI 指揮者的一種社會轉型。

這樣的未來不會從某間公司,或某場革命中突然冒出來,而是經過一個長期演進的過程。從模型設計、語料整合、基礎架構,到實際部署,每一個層次都需要全球共同參與。

開源平台會是這一切的基礎。因為沒有人願意把自己的語料、文化背景與個人偏好,完全交由幾家跨國公司。只有開放架構與分散式訓練,才能實現真正多樣化、在地化的 AI 生態。

楊立坤說得很直白:AI 的未來,不會是奇蹟,也不會是災難,而是「一場大家共同參與的演化過程」。

我自己對這段話大致是支持的。雖然我不贊成所謂的主權 AI 模型,也反對立場過於偏頗的語言模型,我們真正的需求,不過就是訓練出一個能夠理解語意的大腦,然後搭配網路搜尋,或本地的資料庫來回應問題,這樣就已經夠用了。

像我錄影的這一天,ChatGPT 剛剛釋出一個可以「用嘴巴修圖」的功能,這種功能之所以可以成真,就是因為他們讓模型理解圖片,建構世界模型,才能做到更實用的事情。

不管是 Google 推出的 Gemma 3,還是 OpenAI 正在實作的圖形功能,都在印證一件事:理解世界比單純生成語句更重要。

這次感謝楊立坤博士精彩的解說

他這次演講比之前講的都還要好很多

當然也要感謝老黃

感謝NVIDIA

你們竟然會請一個打臉你們的大師

來和你們做這麼深入的對談

今天就到這邊

我們下禮拜再見~掰